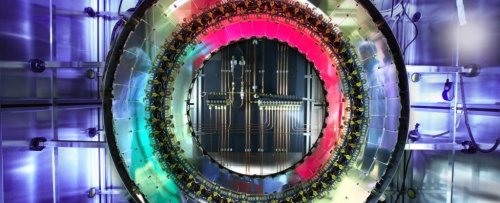

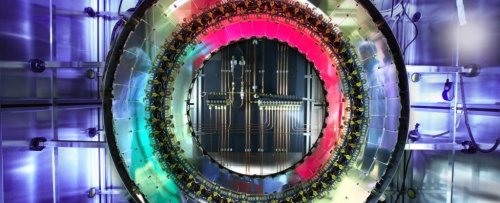

На страницах нашего сайта мы неоднократно рассказывали о Большом Адронном Коллайдере, самом большом и мощном ускорителе частиц на сегодняшний день. Проведенные эксперименты уже позволили ученым найти множество новых, неизвестных ранее субатомных частиц, включая и “неуловимый” бозон Хиггса. А в последнее время физики использовали коллайдер для поиска явлений, выходящих за рамки Стандартной Модели физики элементарных частиц, которые могут обеспечить лучшие объяснения некоторых тонкостей “работы” Вселенной. Но оказывается, что вся череда громких открытий, сделанных при помощи коллайдера, была основана на анализе данных, объем которых составляет менее одного процента от всего объема вырабатываемых данных. Остальные же данные теряются безвозвратно.

26.7-километровый туннель коллайдера используется для разгона частиц к скорости, близкой к скорости света. Два потока частиц, движущиеся в противоположных направлениях, сталкиваются в точках пространства, контролируемых чувствительными датчиками. Даже на минимальном уровне плотности протонных лучей, содержащих по 120 миллиардов протонов, количество столкновений составляет 30 миллионов столкновений в секунду.

Согласно информации, опубликованной на сайте Европейской организации ядерных исследований CERN, один миллиард столкновений в секунду рождает поток данных в 1 петабайт в секунду. И это является самой большой проблемой в нынешнее время, так как поток данных такой скорости попросту невозможно сохранить, не говоря об его должной обработке. “При минимальном уровне в 30 миллионов столкновений нам нужно 2000 петабайт для сохранения результатов типичного 12-часового этапа работы коллайдера. При уровне 150 запусков коллайдера в год для сохранения всех данных потребуется 400 000 петабайт, 400 экзабайт, огромный объем, который мы не можем даже сохранить в настоящее время” – рассказывает Андреас Хекер (Andreas Hoecker), ученый из CERN.

Решением проблемы большого количества данных является, естественно, кардинальное уменьшение их объема. И делается это не за счет каких-либо алгоритмов сжатия информации, для этого недостаточно мощности всех процессоров существующих суперкомпьютеров. Возможности имеющейся в CERN вычислительной техники позволяют сохранить результаты всего 1200 столкновений на каждые 30 миллионов таких случаев. Это составляет 0.004 процента от всего объема, а остальные 99.996 процента, как уже упоминалось выше, теряются безвозвратно.

Такое положение вещей кажется ужасным транжирством, но не все так печально. Явления, которые представляют действительный интерес для ученых, не возникают с такой скоростью. К примеру, бозон Хиггса появляется со скоростью один раз в секунду, а другие события происходят с частотой в десятки и сотни раз в секунду. Для выделения самого интересного из всего потока данных занимаются специальные “триггеры”, устройства, выполняющие предварительную фильтрацию данных преимущественно на аппаратном уровне. Эти триггеры разрабатываются под каждый конкретный случай и настраиваются в соответствии со свойствами искомых частиц, таких, как бозон Хиггса, истинный кварк, W- и Z-бозоны, и д.р.

Конечно, при такой реализации предварительной обработки данных некоторая часть интересных данных теряется вместе с горой ненужного и неинтересного “мусора”. Но оставшаяся информация содержит преимущественно значимые данные, а ее относительно скромный объем уже позволяет провести достаточно глубокую обработку даже в режиме реального времени.

И в заключение следует отметить, что решением описанной выше проблемы является отнюдь не обеспечение возможности сохранения бесполезных в своем большинстве данных. Решением проблемы является создание новых датчиков для коллайдера, в которых будут использованы самые последние достижения современных технологий и которые смогут обеспечить проникновение в глубины неизведанных на сегодняшний день областей физики. К слову, некоторые из таких датчиков появятся на коллайдере в ходе проводимой прямо сейчас очередной его модернизации. А запуск модернизированного коллайдера запланирован на 2025 год.